YouTube’s 2025 AI policy arrived like a sudden earthquake shaking creators across every niche from education to gaming to faceless channels. Many creators feared demonetization content removal or a complete reset for their channels. Yet the truth is more strategic and far more exciting. The updates are strict but they also open an entirely new era where creativity transparency and storytelling matter more than ever. If you understand how the new rules work and adapt early your channel can grow faster than channels that ignore or resist these changes.

This article walks you through every major YouTube AI rule for 2025 in a narrative practical way and gives you a step by step roadmap to not only survive but grow stronger in this new environment.

YouTube’s 2025 AI Policy What Actually Changed

1. Mandatory Disclosure for AI Content

YouTube now requires creators to clearly label:

- AI generated voices

- AI generated humans or faces

- AI generated environments

- Deepfakes

- Scripted content fully produced with AI

- Any reconstructed or “synthetic” scenes

This is no longer optional. If you avoid disclosure YouTube may:

- Reduce reach

- Remove your video

- Give channel warnings

- Disable monetization

However disclosure does not harm your reach if you do it correctly. In fact transparency boosts trust and that leads to more watch time.

2. Stricter Rules on Human Representation

YouTube now protects real individuals from being impersonated. You cannot:

- Use AI to recreate a celebrity voice without labeling

- Create fake statements through synthetic actors

- Make AI avatars that look like real people without permission

Creators using avatars must now clarify whether the character is:

- AI generated

- A fictional representation

- A digital character voiced by the creator

This rule protects viewers but also pushes creators toward stronger storytelling and clearer branding.

3. New Copyright Expectations

AI generated content must still respect copyrights.

For example you cannot:

- Train a model on copyrighted songs and reuse outputs

- Recreate a movie soundtrack with AI

- Generate landscapes or scenes based on protected films

YouTube’s new detector can now spot these patterns even if the video is entirely AI created. The platform will automatically restrict monetization when the risk is high.

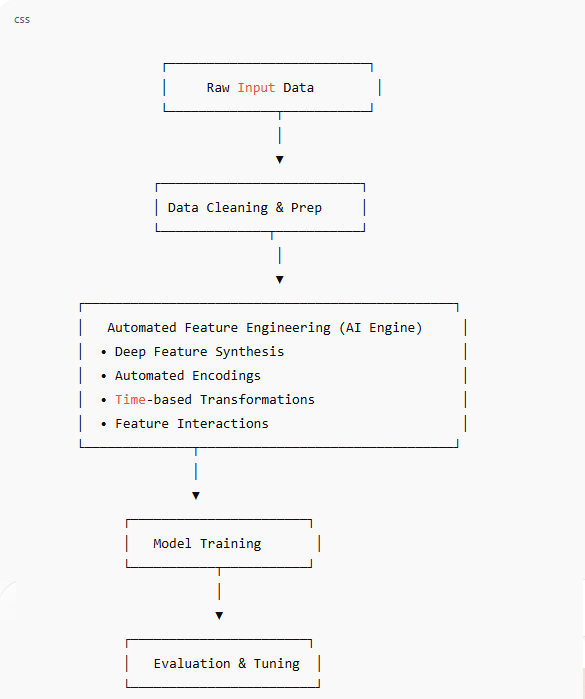

How Smart Creators Can Win Under the 2025 Rules

The creators who grow fastest in 2025 will be those who do not fight the new guidelines but instead build content strategies around them. Here is how.

1. Use AI for Brainstorming Not Final Output

Creators who rely on fully AI generated videos will struggle with identity viewer loyalty and monetization consistency. Instead use AI tools for:

- Script ideas

- Content outlines

- Video structures

- Research summaries

- Visual concepts

But add your own voice camera presence or commentary on top. Even faceless channels can do this by keeping a human layer such as:

- Personal narration

- Real world examples

- Your own storytelling

- Your own editing style

This hybrid model will dominate in 2025.

2. Build Your Signature Voice or Format

YouTube is now rewarding originality more than production value.

Your competitive advantage is not AI visual quality but your unique:

- Tone

- Style

- Pacing

- Humor

- Insight

- Storytelling pattern

Even faceless creators can have a recognizable personality through writing and voice delivery.

3. Use AI Tools to Speed Up Production Without Triggering the Policy

Here is what is still completely safe:

- AI editing assistants

- AI thumbnail enhancement

- AI noise removal

- AI translation

- AI captioning

- AI B-roll for nonhuman scenes

- AI color grading

None of these require disclosure because they modify your original work instead of replacing it.

This is where creators will explode in productivity in 2025.

4. Be Very Clear with Disclosure Without Ruining the Viewer Experience

The biggest fear creators have is that disclosure will make their content feel cheap.

Here is a simple formula to avoid that:

Place the AI disclosure at the very end of the description or in a small line at the start of the video.

Examples:

- “Some visual elements in this video were created using AI tools.”

- “Voice assistance provided by AI narration software.”

- “Portions of this scene contain AI generated environments.”

Short clean and professional.

5. Lean Into Formats YouTube Loves in 2025

YouTube’s algorithm in 2025 is pushing:

- Tutorials

- Mini documentaries

- Short storytelling videos

- Explainer style videos

- Personal commentary

- Reaction and analysis

- Gaming with deep narrative

- Real world skill-based content

Creators who mix human insight with AI efficiency will dominate these niches.

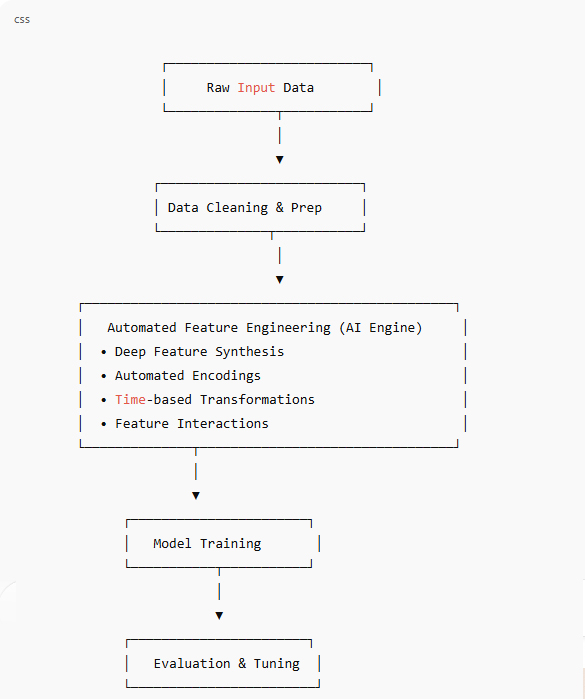

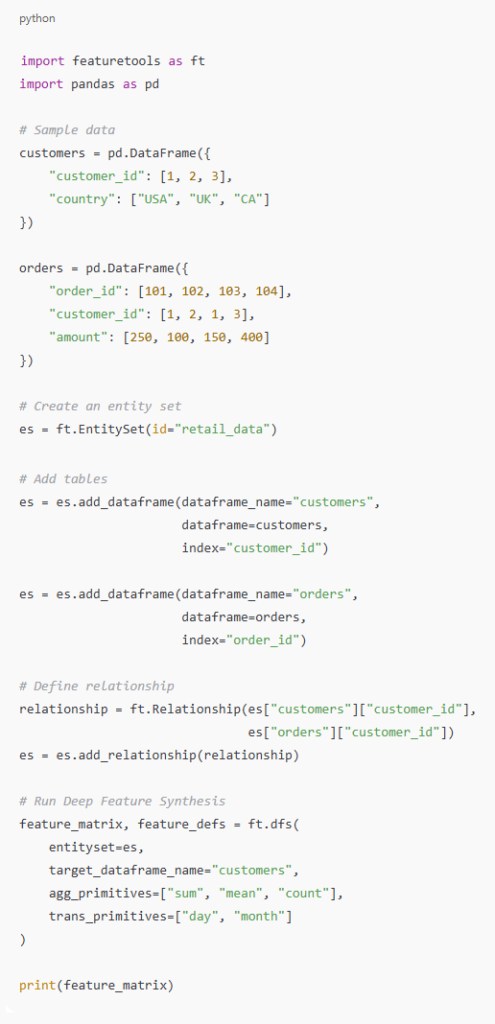

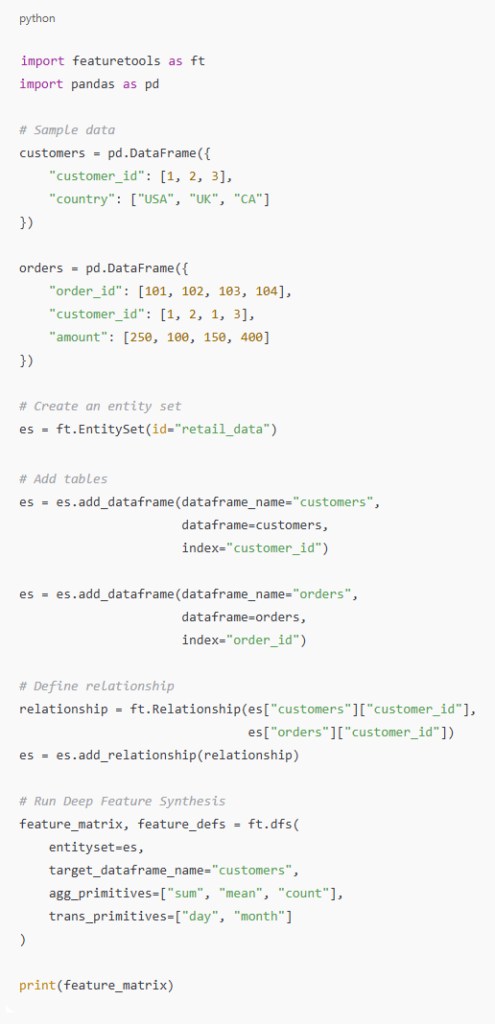

A Real Life Example: How I Started Generating Deep Features Automatically

At the beginning of 2025 I was experimenting with creating dozens of short educational videos every week. Manually scripting each one was painful and slow. So I built a personal workflow that uses AI tools to generate deep structured features for each topic automatically. These features included narrative flow key talking points supporting metaphors contextual examples and alternative phrasings.

Instead of giving me a finished script the model gave me a rich multi layer map. From that map I could quickly build a human sounding professional script with my own style. This approach made my videos more detailed and more coherent while still remaining authentic and fully compliant with YouTube’s policy. AI became my assistant not my replacement.

Conclusion

2025 is not the year AI content dies on YouTube. It is the year lazy AI content dies and meaningful creator led content wins. If you embrace transparency originality and hybrid creation your channel will grow faster than ever before. The creators who succeed in this new era are not the ones who fight the rules. They are the ones who evolve before everyone else does.

2025 في عام YouTube النمو السريع على

بالرغم من سياسة الذكاء الاصطناعي الجديدة

جاءت سياسة الذكاء الاصطناعي لعام 2025 على يوتيوب بمثابة زلزال مفاجئ هزّ صنّاع المحتوى في جميع المجالات من التعليم إلى الألعاب إلى القنوات غير المرئية، خشي العديد من صنّاع المحتوى إزالة المحتوى المُدر للربح أو إعادة ضبط قنواتهم بالكامل، لكن الحقيقة أكثر استراتيجيةً وإثارةً، فصحيحٌ أن التحديثات صارمة لكنها تفتح أيضاً عصراً جديداً كلياً، حيثُ أصبحت الشفافية والإبداع وسرد القصص أكثر أهميةً من أي وقت مضى، فإذا فهمتَ آلية عمل القواعد الجديدة وتكيّفتَ معها مبكراً فستنمو قناتك أسرع من القنوات التي تتجاهل هذه التغييرات أو تقاومها

يُقدّم لك هذا المقال شرحاً عملياً وسردياً لجميع قواعد الذكاء الاصطناعي الرئيسية على يوتيوب لعام 2025 ويمنحك خارطة طريق خطوة بخطوة ليس فقط للبقاء بل للنمو بقوة أكبر في هذه البيئة الجديدة

سياسة يوتيوب للذكاء الاصطناعي لعام ٢٠٢٥: ما الذي تغير فعلياً؟

١. الإفصاح الإلزامي عن محتوى الذكاء الاصطناعي

:يُلزم يوتيوب الآن منشئي المحتوى بوضع علامات واضحة على

الأصوات المُولّدة بالذكاء الاصطناعي •

الأشخاص أو الوجوه المُولّدة بالذكاء الاصطناعي •

البيئات المُولّدة بالذكاء الاصطناعي •

التزييف العميق •

المحتوى المُبرمج والمُنتج بالكامل باستخدام الذكاء الاصطناعي •

أي مشاهد مُعاد بناؤها أو “مُصطنعة” •

:لم يعد هذا الأمر اختيارياً، ففي حال تجنّبك الإفصاح قد يقوم يوتيوب بما يلي

تقليل الوصول •

إزالة الفيديو •

إصدار تحذيرات للقناة •

تعطيل تحقيق الدخل •

ومع ذلك لا يُؤثّر الإفصاح سلباً على وصولك إذا تم ذلك بشكل صحيح، ففي الواقع تُعزّز الشفافية الثقة مما يؤدي إلى زيادة وقت المشاهدة

٢. قواعد أكثر صرامة بشأن تمثيل الأشخاص

: يحمي يوتيوب الآن الأشخاص الحقيقيين من انتحال هوياتهم، إذ يمنعك من القيام بالإجراءت التالية

استخدام الذكاء الاصطناعي لإعادة إنتاج صوت أحد المشاهير دون تصنيف •

إنشاء عبارات مزيفة باستخدام ممثلين اصطناعيين •

إنشاء صور رمزية للذكاء الاصطناعي تشبه أشخاصاً حقيقيين دون إذن •

: يجب على منشئي المحتوى الذين يستخدمون الصور الرمزية توضيح ما إذا كانت الشخصية

مُولّدة من الذكاء الاصطناعي •

تمثيل خيالي •

شخصية رقمية بصوت منشئ المحتوى •

تحمي هذه القاعدة المشاهدين ولكنها تدفع أيضاً منشئي المحتوى نحو سرد قصص أقوى وعلامة تجارية أوضح3

3. توقعات جديدة لحقوق الطبع والنشر

يجب أن يحترم المحتوى المُولّد بالذكاء الاصطناعي حقوق الطبع والنشر

: على سبيل المثال لا يمكنك القيام بالإجراءات التالية

تدريب نموذج على الأغاني المحمية بحقوق الطبع والنشر وإعادة استخدام المخرجات •

إعادة إنتاج موسيقى تصويرية لفيلم باستخدام الذكاء الاصطناعي •

إنشاء مناظر طبيعية أو مشاهد مستوحاة من أفلام محمية •

يمكن لأداة الكشف الجديدة في يوتيوب الآن اكتشاف هذه الأنماط حتى لو كان الفيديو مُولّداً بالكامل بالذكاء الاصطناعي ستُقيّد المنصة تلقائياً تحقيق الدخل عندما يكون الخطر مرتفعاً

كيف يُمكن للمبدعين الأذكياء النجاح في ظل قواعد 2025

سيكون منشئو المحتوى الأسرع نمواً في عام 2025 هم أولئك الذين لا يعارضون الإرشادات الجديدة بل يبنون استراتيجيات محتوى حولها

: إليك الطريقة

١. استخدم الذكاء الاصطناعي للعصف الذهني وليس للإخراج النهائي

سيواجه منشئو المحتوى الذين يعتمدون على مقاطع فيديو مُولّدة بالكامل بالذكاء الاصطناعي صعوبة في تحديد هوية المشاهدين وولاءهم وثبات معدل الربح، استخدم أدوات الذكاء الاصطناعي بدلاً من ذلك لما يلي

أفكار النصوص •

مخططات المحتوى •

هياكل الفيديو •

ملخصات الأبحاث •

المفاهيم البصرية •

ولكن أضف صوتك الخاص سواءً من خلال الكاميرا أو التعليق الصوتي، حتى القنوات التي لا تظهر فيها أي شخصية يمكنها تحقيق ذلك من خلال الحفاظ على طابع إنساني مثل

سرد شخصي •

أمثلة من الواقع •

سرد قصصك الخاص •

أسلوبك الخاص في التحرير •

سيهيمن هذا النموذج الهجين في عام ٢٠٢٥

٢. طوّر أسلوبك أو تنسيقك الخاص

يُقدّر يوتيوب الآن الأصالة أكثر من قيمة الإنتاج

: لا تكمن ميزتك التنافسية في جودة الصورة التي يدعمها الذكاء الاصطناعي، بل في ما تتميز به من

أسلوب •

وتيرة •

حس فكاهة •

رؤية •

نمط سرد القصص •

حتى منشئو المحتوى الذين لا تظهر فيهم شخصيات مميزة، يمكنهم امتلاك شخصية مميزة من خلال الكتابة والأداء الصوتي

٣. استخدم أدوات الذكاء الاصطناعي لتسريع الإنتاج دون التأثير على السياسة

: إليك ما لا يزال آمناً تماماً

مساعدو التحرير بالذكاء الاصطناعي •

تحسين الصور المصغرة بالذكاء الاصطناعي •

إزالة الضوضاء بالذكاء الاصطناعي •

الترجمة بالذكاء الاصطناعي •

التسميات التوضيحية بالذكاء الاصطناعي •

بالذكاء الاصطناعي للمشاهد غير البشرية B-roll لقطات •

تصحيح الألوان بالذكاء الاصطناعي •

لا يتطلب أيٌّ من هذه الأدوات الإفصاح، لأنها تُعدّل عملك الأصلي بدلاً من استبداله

هنا سيشهد منشئو المحتوى زيادةً هائلةً في الإنتاجية في عام ٢٠٢٥

٤. كن واضحاً جداً في الإفصاح دون إفساد تجربة المشاهد

أكبر مخاوف منشئي المحتوى هو أن يُشعرهم الإفصاح برخص محتواهم

: إليك طريقة بسيطة لتجنب ذلك

ضع الإفصاح بالذكاء الاصطناعي في نهاية الوصف أو في سطر صغير في بداية الفيديو

: أمثلة

“تم إنشاء بعض العناصر المرئية في هذا الفيديو باستخدام أدوات الذكاء الاصطناعي” •

“المساعدة الصوتية مُقدمة بواسطة برنامج سرد بالذكاء الاصطناعي” •

“تحتوي أجزاء من هذا المشهد على بيئات مُولّدة بالذكاء الاصطناعي” •

فيديو قصير وواضح واحترافي

٥. اعتمد على الصيغ التي يعشقها يوتيوب في عام ٢٠٢٥

: تشهد خوارزمية يوتيوب في عام ٢٠٢٥ تطوراً ملحوظاً في

البرامج التعليمية •

الأفلام الوثائقية القصيرة •

فيديوهات سرد قصص قصيرة •

فيديوهات توضيحية •

التعليقات الشخصية •

ردود الفعل والتحليل •

الألعاب ذات السرد العميق •

محتوى قائم على مهارات واقعية •

سيسيطر على هذه المجالات المبدعون الذين يمزجون بين البصيرة البشرية وكفاءة الذكاء الاصطناعي

مثال من الحياة الواقعية: كيف بدأتُ بإنشاء ميزات عميقة تلقائياً

في بداية عام ٢٠٢٥ كنتُ أجرب إنشاء عشرات الفيديوهات التعليمية القصيرة أسبوعياً، وكانت كتابة كل فيديو يدوياً أمراً شاقاً وبطيئاً، لذلك أنشأتُ سير عمل شخصياً يستخدم أدوات الذكاء الاصطناعي لإنشاء ميزات منظمة عميقة لكل موضوع تلقائياً، تضمنت هذه الميزات تدفقاً سردياً ونقاط نقاش رئيسية واستعارات داعمة وأمثلة سياقية وعبارات بديلة

بدلاً من إعطائي نصاً جاهزاً منحني النموذج خريطة غنية متعددة الطبقات، فمن خلال هذه الخريطة استطعتُ بسرعة إنشاء نص احترافي بأسلوبي الخاص ليبدو بشرياً، هذا النهج جعل فيديوهاتي أكثر تفصيلاً وتماسكاً مع الحفاظ على أصالتها وامتثالها التام لسياسة يوتيوب أصبح الذكاء الاصطناعي مساعدي لا بديلاً لي

الخلاصة

عام ٢٠٢٥ ليس عام زوال محتوى الذكاء الاصطناعي على يوتيوب بل هو عام زوال محتوى الذكاء الاصطناعي الكسول وسينتصر المحتوى الهادف الذي يقوده المبدعون، فإذا تبنّيتَ الشفافية والأصالة والإبداع الهجين فستنمو قناتك أسرع من أي وقت مضى، وتذكر دائماً أن المبدعون الناجحون في هذا العصر الجديد ليسوا من يتحدون القواعد بل هم من يتطورون قبل غيرهم

You must be logged in to post a comment.