Introduction

A calendar is more than a way to track dates—it’s a powerful tool for analyzing patterns over time. In Power BI, building a dynamic calendar visual allows you to explore performance across days, weeks, months, and years in an interactive and visually appealing way.

In this guide, we’ll walk step by step through creating a professional dynamic calendar visualization in Power BI, supported with examples and DAX code.

1. Why Do You Need a Dynamic Calendar in Power BI?

Most reports rely heavily on the time dimension, but traditional charts often fail to highlight day-by-day patterns. A calendar visual helps you:

- Spot distributions: Identify the busiest and slowest days at a glance.

- Enable easy comparisons: Compare performance across weeks or months.

- Deliver visual impact: Present data in a format users instantly understand.

example: An e-commerce store uses a dynamic calendar to see which days drive the most orders, helping the marketing team plan promotions strategically.

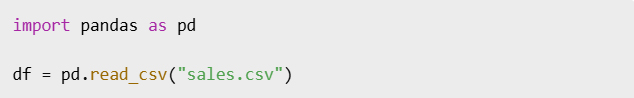

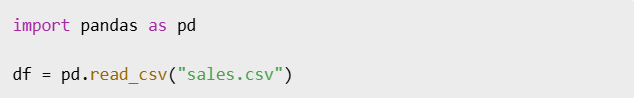

2. Create a Date Table

Before building the visual, you need a proper Date Table. You can generate one in Power BI using DAX:

DateTable =

ADDCOLUMNS (

CALENDAR (DATE(2020,1,1), DATE(2030,12,31)),

"Year", YEAR([Date]),

"Month", FORMAT([Date], "MMMM"),

"MonthNumber", MONTH([Date]),

"Day", DAY([Date]),

"Weekday", FORMAT([Date], "ddd"),

"WeekdayNumber", WEEKDAY([Date],2)

)

Tip: Don’t forget to mark it as a Date Table in Power BI.

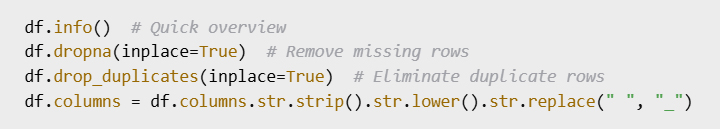

3. Build the Calendar Layout with Matrix Visual

Now let’s transform this into a calendar view using the Matrix visual:

- Add a Matrix visual.

- Place Month and Year on the rows.

- Place Weekday on the columns.

- Use Day or a measure (like total sales) in the values field.

The Matrix will now display your data in a grid resembling a calendar.

4. Make It Interactive

To turn the static calendar into an interactive tool:

- Conditional formatting: Color cells based on values (e.g., green = high sales, red = low).

- Slicers: Allow users to filter by year, month, or product.

- Tooltips: Show detailed insights when hovering over a specific day.

Real-world example: A service company uses tooltips to display daily customer visits and revenue when hovering over a date.

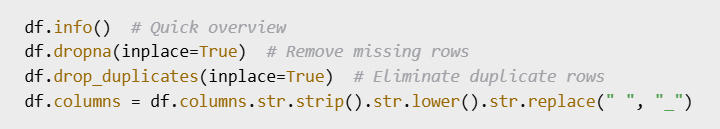

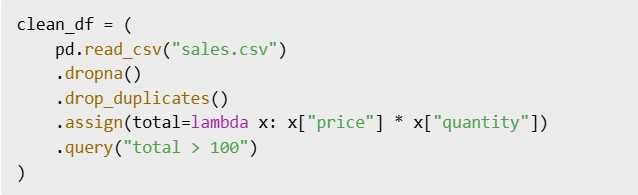

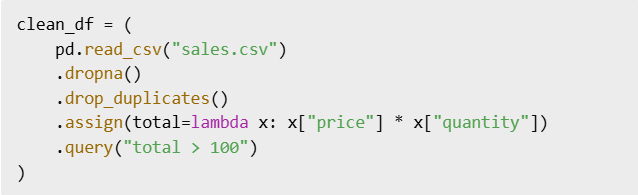

5. Add Dynamic Measures

Measures make your calendar more insightful. For example, to calculate sales:

Total Sales = SUM(Sales[SalesAmount])

Or count daily orders:

Total Orders = COUNTROWS(Sales)

You can then display these measures inside the calendar, making each cell a mini insight point.

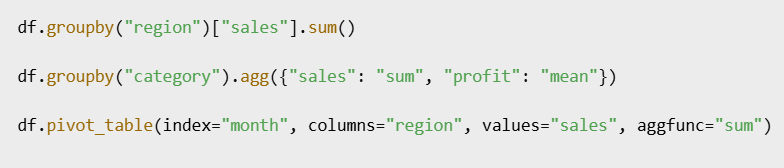

6. Enhance the Visual Design

To polish your calendar visualization:

- Use Custom Visuals like Calendar by MAQ Software from AppSource.

- Apply Themes that align with your company branding.

- Add Year-over-Year comparisons for more advanced analytics.

Conclusion

Building a dynamic calendar visual in Power BI is not just about aesthetics—it’s about making time-based insights accessible and actionable. With a Date Table, a Matrix visual, and some interactivity, you can transform raw numbers into a calendar that tells a story.

Next time you design a Power BI report, try including a calendar visual—you’ll be surprised how much clarity it brings to your data.

Power BI من التواريخ إلى الرؤى – إنشاء تقويم تفاعلي في

مقدمة

التقويم ليس مجرد وسيلة لتتبع التواريخ، بل هو أداة فعّالة لتحليل الأنماط بمرور الوقت

: يتيح لك إنشاء عرض مرئي ديناميكي للتقويم Power BI ففي

استكشاف الأداء على مدار الأيام والأسابيع والأشهر والسنوات بطريقة تفاعلية وجذابة بصرياً

في هذا الدليل سنشرح خطوة بخطوة كيفية إنشاء عرض احترافي

DAX مدعوماً بأمثلة وأكواد Power BI للتقويم الديناميكي في

1. Power BI لماذا تحتاج إلى تقويم ديناميكي في

تعتمد معظم التقارير بشكل كبير على بُعد الوقت ولكن المخططات التقليدية غالباً ما تفشل في إبراز الأنماط اليومية، يساعدك عرض التقويم المرئي على

تحديد التوزيعات: تحديد الأيام الأكثر ازدحاماً والأبطأ في لمحة

تسهيل المقارنات: مقارنة الأداء على مدار الأسابيع أو الأشهر

تقديم تأثير بصري: عرض البيانات بتنسيق يفهمه المستخدمون فوراً

مثال: يستخدم متجر للتجارة الإلكترونية تقويماً ديناميكياً لمعرفة الأيام التي تشهد أكبر عدد من الطلبات مما يساعد فريق التسويق على التخطيط الاستراتيجي للحملات الترويجية

٢. إنشاء جدول تواريخ

قبل إنشاء المخطط ستحتاج إلى جدول تواريخ مناسب

DAX باستخدام Power BI فيمكنك إنشاء واحد في

DateTable =

ADDCOLUMNS (

CALENDAR (DATE(2020,1,1), DATE(2030,12,31)),

"Year", YEAR([Date]),

"Month", FORMAT([Date], "MMMM"),

"MonthNumber", MONTH([Date]),

"Day", DAY([Date]),

"Weekday", FORMAT([Date], "ddd"),

"WeekdayNumber", WEEKDAY([Date],2)

)

Power BI نصيحة: لا تنسى تحديده كجدول تواريخ في

Matrix Visual ٣. أنشئ تخطيط التقويم باستخدام

Matrix Visual لنحوّل الآن هذا إلى عرض تقويم باستخدام

Matrix Visual أضف

ضع الشهر والسنة في الصفوف

ضع يوم الأسبوع في الأعمدة

استخدم اليوم أو مقياساً (مثل إجمالي المبيعات) في حقل القيم

الآن بياناتك في شبكة تشبه التقويم Matrix ستعرض

مثال: تخطيط تقويم يعرض عدد الطلبات اليومية في عرض شهري

٤. اجعله تفاعلياً

لتحويل التقويم الثابت إلى أداة تفاعلية

التنسيق الشرطي: لوّن الخلايا بناءً على القيم (مثلاً: الأخضر = أعلى مبيعات، الأحمر = أقل مبيعات)

المُقسّمات: تسمح للمستخدمين بالتصفية حسب السنة أو الشهر أو المنتج

تلميحات الأدوات: عرض رؤى تفصيلية عند تمرير مؤشر الماوس فوق يوم محدد

مثال: تستخدم شركة خدمات تلميحات لعرض زيارات العملاء اليومية والإيرادات عند تمرير مؤشر الماوس فوق تاريخ معين

5. إضافة مقاييس ديناميكية

:تجعل المقاييس تقويمك أكثر دقة، فعلى سبيل المثال، لحساب المبيعات

Total Sales = SUM(Sales[SalesAmount])

: أو لحساب الطلبات اليومية

Total Orders = COUNTROWS(Sales)

يمكنك بعد ذلك عرض هذه المقاييس داخل التقويم مما يجعل كل خلية بمثابة نقطة إدراك صغيرة

6. تحسين التصميم المرئي

لتحسين عرض تقويمك: استخدم عناصر مرئية مخصصة

AppSource من MAQ Software من Calendar مثل

طبّق سمات تتوافق مع هوية شركتك

أضف مقارنات سنوية لتحليلات أكثر تقدماً

الخلاصة

Power BI لا يقتصر إنشاء عرض تقويم ديناميكي في

على الجانب الجمالي فحسب بل يهدف أيضاً إلى جعل الرؤى الزمنية في متناول الجميع وقابلة للتنفيذ، فباستخدام جدول بيانات وعرض مصفوفة وبعض التفاعل يمكنك تحويل الأرقام الخام إلى تقويم يروي قصة

Power BI في المرة القادمة التي تصمم فيها تقرير

جرّب تضمين عرض تقويم – ستندهش من مدى الوضوح الذي يُضفيه على بياناتك

You must be logged in to post a comment.