Introduction: A Glimpse Into the Data-Driven Decade

By mid-2025, it’s hard to ignore just how central data analytics has become in shaping the modern world. Over the past decade, data has transitioned from a niche back-office function to a pillar of strategic decision-making across nearly every industry. Governments, corporations, non-profits, and startups alike have invested heavily in data infrastructure, talent, and tools to harness the predictive and diagnostic power of information. In this data-driven era, organizations that failed to embrace analytics risked irrelevance. Yet now, the conversation is beginning to shift. With the rise of automation, increasing regulatory constraints, and a maturing marketplace, many professionals and business leaders are asking a sobering question: Is the window of opportunity in data analytics starting to close? This article explores that question through the lens of innovation, labor dynamics, regulatory change, and strategic transformation.

Automation and Generative AI: Shifting the Value Proposition

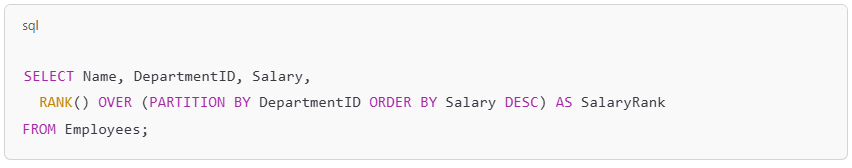

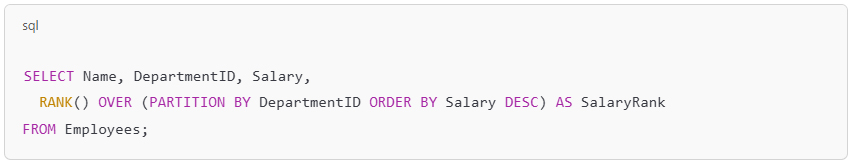

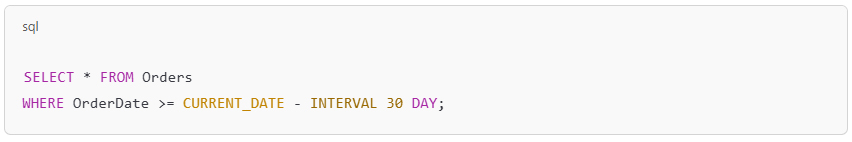

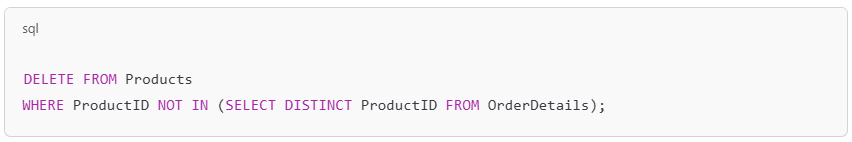

One of the most significant developments reshaping data analytics in 2025 is the rise of generative AI and automated analytical tools. The introduction of large language models (LLMs), AutoML systems, and user-friendly interfaces has made it dramatically easier for non-technical users to perform complex data tasks. Business users can now query databases using natural language, generate predictive models without writing a single line of code, and visualize insights in seconds with AI-assisted dashboards. On the surface, this democratization seems like a triumph—organizations can make data-informed decisions faster and more affordably. But this progress also raises fundamental questions about the role of the traditional data analyst. As machines increasingly handle the technical execution, the core value of the human analyst is being reevaluated. Analysts are now expected to do more than produce models—they must contextualize findings, apply domain-specific judgment, and align recommendations with organizational strategy. The opportunity isn’t gone—but it’s moving up the value chain, demanding greater business fluency and creative problem-solving from data professionals.

Talent Saturation and the Evolving Skill Landscape

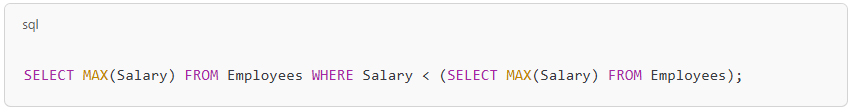

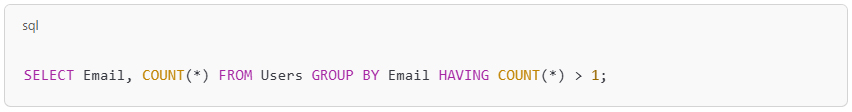

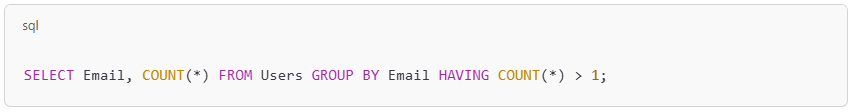

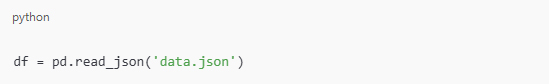

Between 2015 and 2023, the exploding demand for data professionals sparked a global wave of upskilling. Universities launched new degrees, online platforms offered certification bootcamps, and employers invested in internal training. By 2025, this momentum has resulted in an abundant talent pool—especially at the entry level. Roles that once required rare skills are now more accessible, and basic competencies in Python, SQL, and data visualization are often considered standard. As a result, competition has intensified, and salaries for junior roles have plateaued or declined in some regions. The most sought-after professionals today are not just data-literate—they are domain experts who can speak the language of the industry they serve. For example, a data scientist with deep knowledge of supply chain operations is more valuable to a logistics company than a generalist analyst with broader but shallower capabilities. The market no longer rewards technical skills alone; instead, it favors hybrid professionals who bring cross-disciplinary insight and the ability to turn raw data into strategic intelligence.

Regulatory Constraints and the Ethics of Data Use

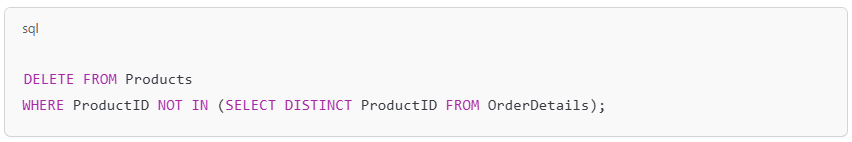

As the power of data has grown, so too have the concerns around how it is collected, stored, and applied. In 2025, data privacy is no longer a peripheral issue—it’s at the heart of digital governance. Stringent regulatory frameworks such as the General Data Protection Regulation (GDPR), the California Consumer Privacy Act (CCPA), and new legislation emerging across Asia and Latin America have fundamentally altered the landscape. Organizations must now navigate a complex web of compliance, consent, data sovereignty, and transparency. Additionally, high-profile data breaches and ethical missteps have made the public more skeptical about how their information is used. As a result, companies are increasingly investing in privacy-preserving technologies like differential privacy, federated learning, and synthetic data. This environment places new responsibilities on data professionals, who must balance analytical ambition with legal and ethical prudence. The opportunity to innovate remains—but it must now be done within a framework of accountability, trust, and regulatory foresight.

Organizational Maturity: From Excitement to Execution

In the early years of the data revolution, many organizations embraced analytics with a sense of experimental enthusiasm. Data teams were given free rein to explore, build models, and produce dashboards—often with little scrutiny over business outcomes. In 2025, that phase has largely passed. Executives are demanding clear ROI on data investments. Boards want to see how analytics drives revenue, reduces costs, or creates competitive advantage. This pressure has led to a more mature approach to data operations. Rather than treating data science as a standalone function, organizations are embedding analytics within core business units—ensuring that insights are not only generated but also implemented. Analysts and data scientists are now working side-by-side with marketing, finance, operations, and product teams to shape initiatives and measure success. This evolution requires professionals to be as comfortable in a business meeting as they are with a Jupyter notebook. The data analytics field is not contracting—it’s consolidating into a more structured, accountable, and business-oriented discipline.

Conclusion: A Tighter Window, But a Deeper Opportunity

So, is the window of opportunity closing for data analytics in 2025? The answer depends on how you define opportunity. For those who seek easy entry and quick rewards, the landscape is indeed more challenging. The influx of talent, automation of routine tasks, and rising expectations mean that superficial skills are no longer enough. But for those willing to adapt, specialize, and deepen their impact, the opportunities are arguably greater than ever. The field is evolving from an experimental frontier to a critical enterprise function. It demands a new kind of professional—one who can navigate technology, ethics, business, and human behavior. In that sense, the window hasn’t closed—it’s simply moved higher. Those who reach for it with a broader set of skills and a deeper understanding of context will find it still wide open.

عام ٢٠٢٥ وتحليل البيانات: هل تضيق نافذة الفرص؟

مقدمة: لمحة عن عقد البيانات

مع انتصاف عام 2025 يصعب تجاهل الدور المحوري الذي اكتسبته تحليلات البيانات في تشكيل عالمنا الحديث، فعلى مدار العقد الماضي تحولت البيانات من وظيفة إدارية متخصصة إلى ركيزة أساسية في صنع القرار الاستراتيجي في جميع القطاعات تقريباً، وقد استثمرت الحكومات والشركات والمنظمات غير الربحية والشركات الناشئة على حد سواء بكثافة في البنية التحتية للبيانات والمواهب والأدوات اللازمة لتسخير القوة التنبؤية والتشخيصية للمعلومات، ففي هذا العصر الذي تعتمد فيه البيانات على البيانات تُواجه المؤسسات التي لم تتبنَّ التحليلات خطر فقدان أهميتها، ومع ذلك بدأ النقاش يتحول الآن، فمع صعود الأتمتة وتزايد القيود التنظيمية ونضوج السوق يطرح العديد من المهنيين وقادة الأعمال سؤالاً جاداً: هل بدأت نافذة الفرص المتاحة في تحليلات البيانات تضيق؟ تستكشف هذه المقالة هذا السؤال من منظور الابتكار وديناميكيات العمل والتغيير التنظيمي والتحول الاستراتيجي

الأتمتة والذكاء الاصطناعي التوليدي: تغيير عرض القيمة

يُعدّ ظهور الذكاء الاصطناعي التوليدي وأدوات التحليل الآلي من أهم التطورات التي تُعيد تشكيل تحليلات البيانات في عام 2025

AutoML وأنظمة (LLMs) وقد سهّل إدخال نماذج اللغات الكبيرة

والواجهات سهلة الاستخدام بشكل كبير على المستخدمين غير التقنيين أداء مهام البيانات المعقدة، فأصبح بإمكان مستخدمي الأعمال الآن الاستعلام عن قواعد البيانات باستخدام اللغة الطبيعية وإنشاء نماذج تنبؤية دون الحاجة إلى كتابة سطر واحد من التعليمات البرمجية وتصور الرؤى في ثوانٍ معدودة باستخدام لوحات معلومات مدعومة بالذكاء الاصطناعي، فللوهلة الأولى يبدو هذا التحول الديمقراطي بمثابة انتصار – إذ يُمكن للمؤسسات اتخاذ قرارات مستنيرة بالبيانات بشكل أسرع وبتكلفة أقل، إلا أن هذا التقدم يثير أيضاً تساؤلات جوهرية حول دور محلل البيانات التقليدي، فمع تزايد تولي الآلات للتنفيذ الفني تُعاد تقييم القيمة الأساسية للمحلل البشري، إذ يُتوقع من المحللين الآن أن يفعلوا أكثر من مجرد إنتاج النماذج – بل يجب عليهم وضع النتائج في سياقها الصحيح وتطبيق أحكام خاصة بمجال معين ومواءمة التوصيات مع استراتيجية المؤسسة، لم تنتهِ الفرصة بعد بل إنها تتقدم في سلسلة القيمة مطالبةً متخصصي البيانات بإتقان أكبر للأعمال وإبداع في حل المشكلات

تشبع المواهب وتطور مشهد المهارات

بين عامي 2015 و2023 أشعل الطلب المتزايد على متخصصي البيانات موجة عالمية من الارتقاء بالمهارات، إذ أطلقت الجامعات برامج دراسية جديدة وقدمت منصات إلكترونية دورات تدريبية للحصول على شهادات واستثمر أصحاب العمل في التدريب الداخلي، فبحلول عام 2025 أدى هذا الزخم إلى وفرة في المواهب لا سيما في مستوى المبتدئين، فأصبحت الأدوار التي كانت تتطلب مهارات نادرة في السابق أكثر سهولة الآن

SQLوغالباً ما تُعتبر الكفاءات الأساسية في بايثون و

وتصور البيانات أساسية، ونتيجة لذلك اشتدت المنافسة وتوقفت رواتب المناصب المبتدئة أو انخفضت في بعض المناطق، وعليه فإن أكثر المتخصصين طلباً اليوم ليسوا مجرد متعلمين في مجال البيانات بل هم خبراء في هذا المجال يتحدثون لغة الصناعة التي يخدمونها، فعلى سبيل المثال يُعدّ عالم البيانات ذو المعرفة العميقة بعمليات سلسلة التوريد أكثر قيمةً لشركة لوجستية من محلل عامّ بقدرات أوسع وإن كانت سطحية، ولم يعد السوق يكافئ المهارات التقنية فحسب بل يُفضّل المهنيين الهجينين الذين يُقدّمون رؤىً متعددة التخصصات والقدرة على تحويل البيانات الخام إلى معلومات استخباراتية استراتيجية

القيود التنظيمية وأخلاقيات استخدام البيانات

مع تنامي قوة البيانات تزايدت المخاوف بشأن كيفية جمعها وتخزينها وتطبيقها، ففي عام 2025 لم تعد خصوصية البيانات مسألةً هامشية بل أصبحت في صميم الحوكمة الرقمية، فقد غيّرت الأطر التنظيمية الصارمة

(GDPR) مثل اللائحة العامة لحماية البيانات

(CCPA) وقانون خصوصية المستهلك في كاليفورنيا

والتشريعات الجديدة الناشئة في جميع أنحاء آسيا وأمريكا اللاتينية غيّرت المشهدَ بشكل جذري، إذ يجب على المؤسسات الآن التعامل مع شبكة معقدة من الامتثال والموافقة وسيادة البيانات والشفافية، بالإضافة إلى ذلك أدت خروقات البيانات البارزة والأخطاء الأخلاقية إلى زيادة تشكيك الجمهور في كيفية استخدام معلوماتهم، نتيجةً لذلك تستثمر الشركات بشكل متزايد في تقنيات الحفاظ على الخصوصية مثل الخصوصية التفاضلية والتعلم الفيدرالي والبيانات التركيبية، فتُلقي هذه البيئة بمسؤوليات جديدة على عاتق متخصصي البيانات الذين يجب عليهم الموازنة بين الطموح التحليلي والحصافة القانونية والأخلاقية، إذ لا تزال فرصة الابتكار قائمة ولكن يجب أن يتم ذلك الآن في إطار من المساءلة والثقة والاستشراف التنظيمي

النضج التنظيمي: من الحماس إلى التنفيذ

في السنوات الأولى لثورة البيانات تبنّت العديد من المؤسسات التحليلات بحماس تجريبي، فمُنحت فرق البيانات حرية كاملة لاستكشاف البيانات وبناء النماذج وإنتاج لوحات المعلومات غالباً مع تدقيق محدود لنتائج الأعمال، ففي عام 2025 انقضت هذه المرحلة إلى حد كبير، إذ يطالب المدراء التنفيذيون بعائد استثمار واضح على استثمارات البيانات، وترغب مجالس الإدارة في معرفة كيف تُعزز التحليلات الإيرادات وتُخفض التكاليف أو تُنشئ ميزة تنافسية، وقد أدى هذا الضغط إلى نهج أكثر نضجاً لعمليات البيانات، فبدلاً من اعتبار علم البيانات وظيفة مستقلة تُدمج المؤسسات التحليلات ضمن وحدات الأعمال الأساسية مما يضمن ليس فقط توليد الرؤى بل تنفيذها أيضاً ويعمل المحللون وعلماء البيانات الآن جنباً إلى جنب مع فرق التسويق والمالية والعمليات والمنتجات لصياغة المبادرات وقياس النجاح، ويتطلب هذا التطور من المهنيين أن يكونوا مرتاحين في اجتماعات العمل

Jupyter كما هم مع دفتر ملاحظات

إذاً مجال تحليلات البيانات لا يتقلص بل يتجه نحو تخصص أكثر هيكلية ومساءلة وتركيزاً على الأعمال

الخلاصة: نافذة أضيق لكن فرصة أعمق

إذاً هل تُغلق نافذة الفرص أمام تحليلات البيانات في عام ٢٠٢٥؟ يعتمد الجواب على كيفية تعريفك للفرصة، فبالنسبة لمن يسعون إلى دخول سهل ومكافآت سريعة فإن المشهد أكثر صعوبة، فتدفق المواهب وأتمتة المهام الروتينية وارتفاع التوقعات يعني أن المهارات السطحية لم تعد كافية، أما بالنسبة لمن يرغبون في التكيف والتخصص وتعميق تأثيرهم فيمكن القول إن الفرص أكبر من أي وقت مضى، فهذا المجال يتطور من مجرد مجال تجريبي إلى وظيفة مؤسسية حيوية، إذ يتطلب نوعاً جديداً من المهنيين – شخصاً قادراً على التعامل مع التكنولوجيا والأخلاقيات والأعمال والسلوك البشري، وبهذا المعنى لم تُغلق النافذة بل توسعت! أما أولئك الذين يسعون إليها بمجموعة أوسع من المهارات وفهم أعمق للسياق فسيجدونها لا تزال مفتوحة على مصراعيها

You must be logged in to post a comment.